Как закрыть страницу от индексации в robots.txt

"закрыть страницу от индексации в robots.txt" - ка можно закрывать от индексации страницу в robots.txt

Подробно о закрытии страницы в robots.txt

- Запрещаем индексацию страницы в robots.txt

- Как проверить - запрещена ли страница к индексации в robots.txt

- Как запретить страницы к индексации в robots.txt

- Как запретить к индексации в robots.txt страницы с get запросом(с вопросом).

Ищем/разбираем инструменты для закрытия страницы от индексации в robots.txt

Как вы наверное знаете... в "robots.txt" можно запретить индексацию страниц с помощью директивы :

Как запретить индексацию одной страницы в robots.txt?

Для того, чтобы запретить индексацию одной страницы, вам потребуется.

Давайте разберем конкретный пример - запрета индексации определенной/одной страницы на сайте!:

Какую страницу будем запрещать к индексации?

Нам нужна конкретная - одна страница, чтобы можно было запретить индексацию этой страницы в robots.txt. Это будет живая, реальная страница у меня на сайте:

Я предполагаю... что Вы знаете где находится robots.txt

Открываем его(robots.txt) в любом редакторе кода, даже обычный блокнот подойдет.

И записываем наш адрес страницы без домена вот таким образом:

Данный пример вы можете проверить(что он живой...) здесь

Как проверить - запрещена ли страница к индексации в robots.txt

Далее... переходим к самому интересному... Вы запретили индексировать определенную страницу...

Но как проверить, что данная страница запрещена к индексации или нет?

Просто так.. вы этого не узнаете... для этого потребуется какой-то сайт онлайн, который умел бы определить - запрещена ли данная страница к индексации?

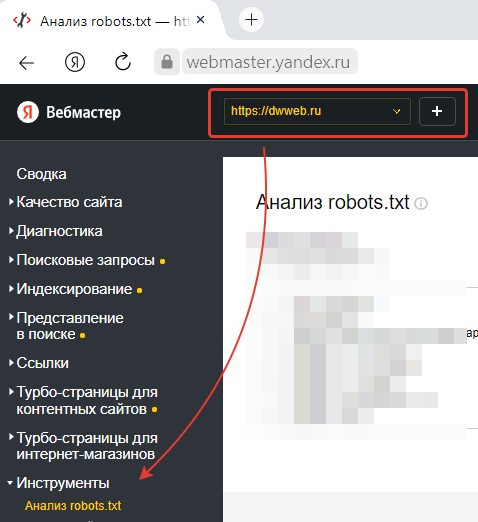

Рассмотрим в качестве такого сервиса - Яндекс вебмастерЗаходим в Яндекс вебмастер, если у вас несколько сайтов, то в выпадающем окне выбираем сайт.

Идем до ссылки "инструменты" - нажимаем.

В выпавшем окне видим "Анализ robots.txt"

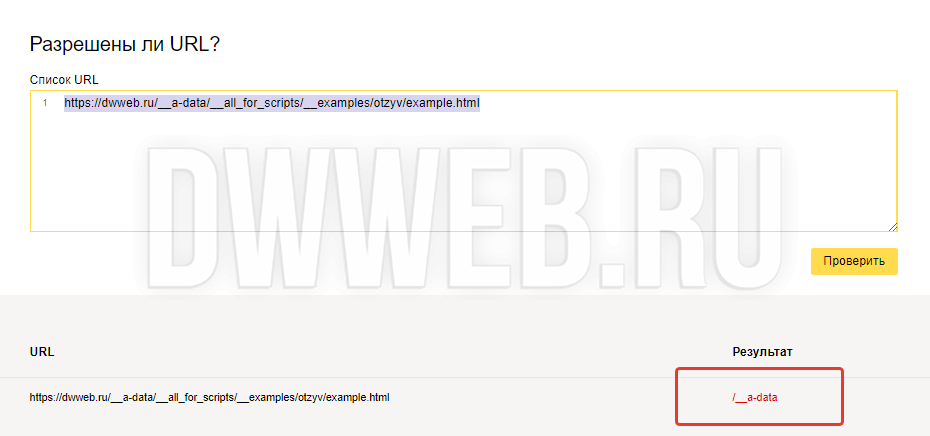

В окне "Анализ robots.txt" - опускаемся до самого низа до формы "Разрешены ли URL?".

1). Вставляем в поле тот адрес, который хотим определить запрещена ли индексация данной страницы:2). Нажимаем "проверить" индексацию.

И далее мы видим... что наша ссылка имеет красный цвет..., что собственно и означает, что моя приведенная ссылка на страницу не индексируется, как и сама страница!

Как запретить страницы для индексации в robots.txt

Надеюсь... с запретом одной страницы для индексации в robots.txt - вы разобрались...

Перейдем к запрету индексации множества страниц.

Для того, чтобы запретить несколько страниц к индексации нам понадобится:

Какой-то из свойств адреса "страниц" - который будет повторяться во многих страницах.

Это может быть папка, которая стоит между доменом и именем страницы:

Нам опять потребуется живая страница - она будет подопытным:

Я хочу запретить все страницы, которые находятся в папке "__a-data"

Прописываем "Disallow" - вот таким образом:

Проверяем "Disallow" в robots.txt- аналогично:

Идеи до поля... Разрешены ли URL?

Вставляем наш адрес и нажимаем проверить:

Скриншот красноречивее слов - как видим... нам демонстрируется та строка в "robots.txt" под которое правило подпадает данная страница - все страницы, которые имеет в своем составе папку

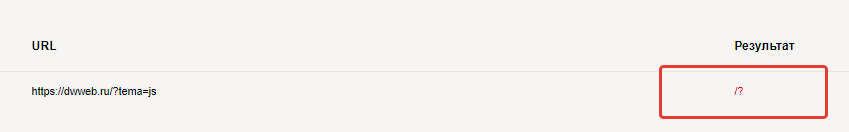

Как запретить к индексации в robots.txt страницы с get запросом(с вопросом).

Предположим, что у вас стоит задача запретить все страницы с get запросом в ссылке.

И нам опять нужен живой пример, разберем вот на эттом адресе:

Для этого нам опять потребуется директива "Disallow". После слеша ставим вопросительный знак... и этого достаточно!

Проверяем запрет индексации страниц с get запросом:

Как видим.... наше правило "запрета индексации" в файле robots.txt сработало!

Этим вы очень поможете проекту! Заранее огромное спасибо!